작지만 강력한 솔라 미니를 소개합니다

2024/01/25 | 작성자: 최유정 (테크니컬 라이터)30B 미만에서 찾을 수 있는 최고의 모델

업스테이지의 사전 학습된 대규모 언어 모델(LLM)인 Solar의 시대에 오신 것을 환영합니다. 2023년 12월, 솔라 미니는 허깅 페이스의 오픈 LLM 리더보드에서 정점에 도달하며 큰 반향을 일으켰습니다. 훨씬 적은 수의 매개변수를 사용하는 Solar Mini는 GPT-3.5와 비슷한 수준의 응답을 제공하지만 2.5배 더 빠릅니다. Solar Mini가 성능 저하 없이 LLM 모델의 다운사이징을 혁신적으로 개선한 방법을 안내해 드리겠습니다.

모델 살펴보기 :

소규모 LLM이 필요한 이유

대형 언어 모델(LLM)을 실제 애플리케이션에 통합하는 데 있어 크기는 중요한 요소가 되었습니다. 작은 모델의 가장 큰 장점은 계산 시간이 단축되어 응답성과 효율성이 향상된다는 점입니다. 이는 특정 도메인 및 서비스에 맞게 맞춤화하기가 더 간단하기 때문에 최적화에 필요한 인력이 줄어든다는 의미로 해석할 수 있습니다. 또한 크기가 작아 온디바이스 배포가 가능하므로 사용자의 로컬 디바이스에 직접 AI 기능을 제공하는 분산형 접근 방식이 용이합니다. 이는 접근성을 향상시킬 뿐만 아니라 광범위한 GPU 리소스에 대한 의존도를 줄여 더욱 새롭고 경제적인 AI 솔루션을 위한 기반을 마련합니다.

태양의 속도

컴팩트한 크기, 강력한 성능

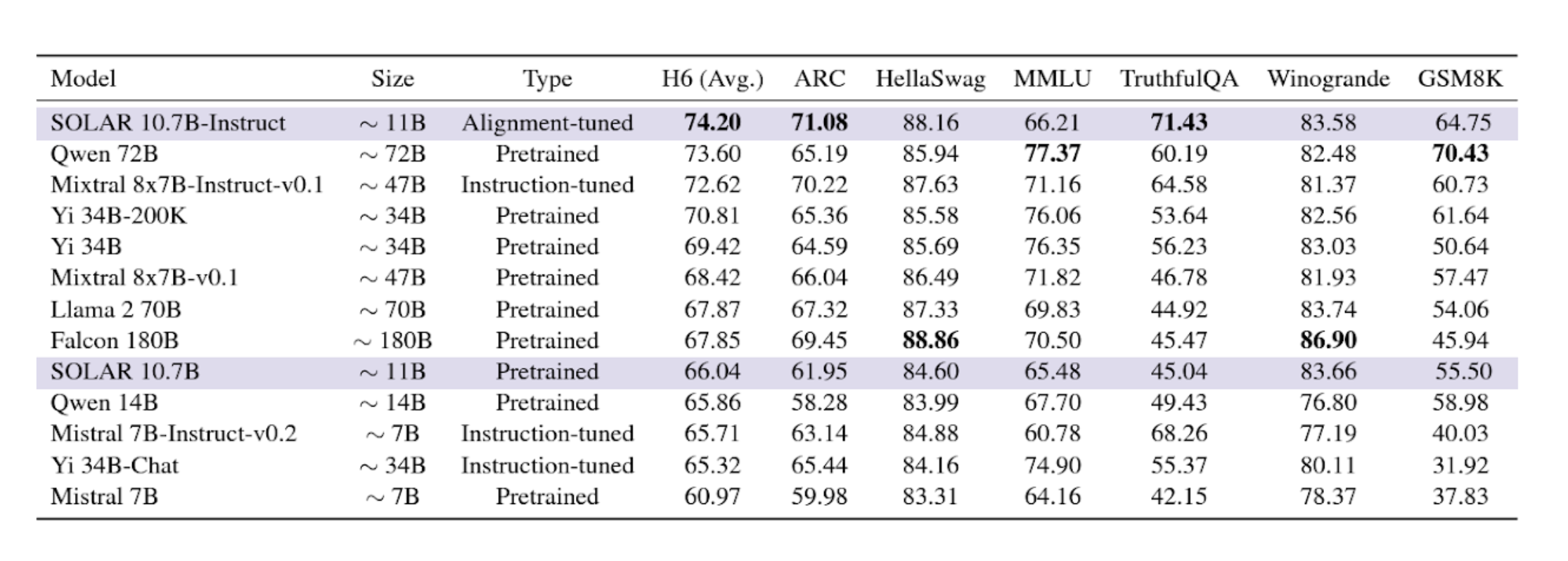

솔라 미니는 뛰어난 성능을 위해 큰 크기가 필요하지 않다는 것을 증명합니다. 다양한 벤치마크에서 라마2, 미스트랄 7B, 코알파카, KULLM과 같은 경쟁사 제품을 압도적으로 앞섰습니다.

다른 최고 성능 모델과 함께 Solar 10.7B 및 Solar 10.7B-Instruct에 대한 평가 결과. (출처: Solar 10.7B: 간단하면서도 효과적인 뎁스 업스케일링을 통한 대규모 언어 모델 확장)

태양광 미니 구축

기본 사항

Solar Mini의 기본 아키텍처는 32층 라마 2 구조를 기반으로 하며, 라마 2 아키텍처와 호환되는 최고 성능의 모델 중 하나인 미스트랄 7B의 사전 학습된 가중치로 초기화됩니다.

뎁스 업스케일링(DUS)

솔라 미니는 어떻게 컴팩트한 크기를 유지하면서도 놀라운 성능을 발휘할 수 있었을까요? 저희의 스케일링 방법인 '뎁스 업스케일링'(DUS)은 깊이별 스케일링과 지속적인 사전 훈련으로 구성됩니다. DUS를 사용하면 전문가 혼합과 같은 다른 스케일링 방법보다 훨씬 간단하고 효율적으로 작은 모델을 확대할 수 있습니다.

Mixture of Experts (MoE)과 달리 DUS는 복잡한 변경이 필요하지 않습니다. 추가 모듈이나 역동성이 필요하지 않으며, DUS는 HuggingFace와 같이 사용하기 쉬운 LLM 프레임워크와 즉시 호환되며 모든 트랜스포머 아키텍처에 적용할 수 있습니다.(논문 읽기 → )

계속되는 사전 교육

뎁스 업 스케일링 후에는 모델이 기본 LLM보다 성능이 저하됩니다. 따라서 스케일링된 모델의 성능을 회복하기 위해 지속적인 사전 훈련 단계가 적용됩니다.

인스트럭션 튜닝

이 단계에서는 한국어에 특화된 인스트럭션 튜닝을 거치는데, 이 단계에서 모델은 QA(질문과 답변) 형식의 지침을 따르도록 훈련받습니다.

정렬 조정

이 단계에서 인스트럭션 튜닝 모델은 인간 또는 강력한 AI의 선호도에 맞게 학습됩니다.

고급 구성 요소와 함께 Solar 사용

RAG

Solar Mini는 특히 RAG 시스템과 잘 작동합니다. LLM이 커질수록 사전 학습된 파라메트릭 지식에 더 많이 의존하여 질문에 답하게 됩니다. Solar Mini는 RAG를 효과적으로 활용하여 출력의 정밀도와 관련성을 높임으로써 정확성과 신뢰성을 강화합니다.

어떤 문서에서든 표와 그림을 추출하는 모델을 보유하고 있습니다. PDF, PNG, JPG 데이터는 모두 OCR 및 레이아웃 분석 모듈을 통해 처리할 수 있습니다. 읽기 순서에 따라 요소를 직렬화하고 출력을 HTML로 변환하면 바로 LLM에 입력할 수 있습니다.

Solar Mini는 Apache 2.0 라이선스에 따라 공개적으로 제공됩니다.

더 보기 : 종이 읽기 / 허깅 페이스에 사용해보기 / 포에 사용해보기